本研修シリーズは、基礎からエンジニアリング、ガバナンスまでを繋ぐ「AI統合マスター」への完全な航路図を提供します。

それぞれのモジュールが独立しながらも、相互に接続された強力なエコシステムを形成しています。

〜 仕組みを「解剖」し、リスクを「無効化」する。

次世代ビジネスを加速させる、最強のAIリテラシー。 〜

本研修シリーズは、基礎からエンジニアリング、ガバナンスまでを繋ぐ「AI統合マスター」への完全な航路図を提供します。

それぞれのモジュールが独立しながらも、相互に接続された強力なエコシステムを形成しています。

| 機能比較 | Gemini 1.5 Pro | Gemini 3.0 (Latest) |

|---|---|---|

| 回答速度 | 標準 | 約2.5倍 / 瞬時 |

| 自律性 | 指示待ち | エージェント(行動計画) |

| マルチモーダル | 対応 | ネイティブ完全統合 |

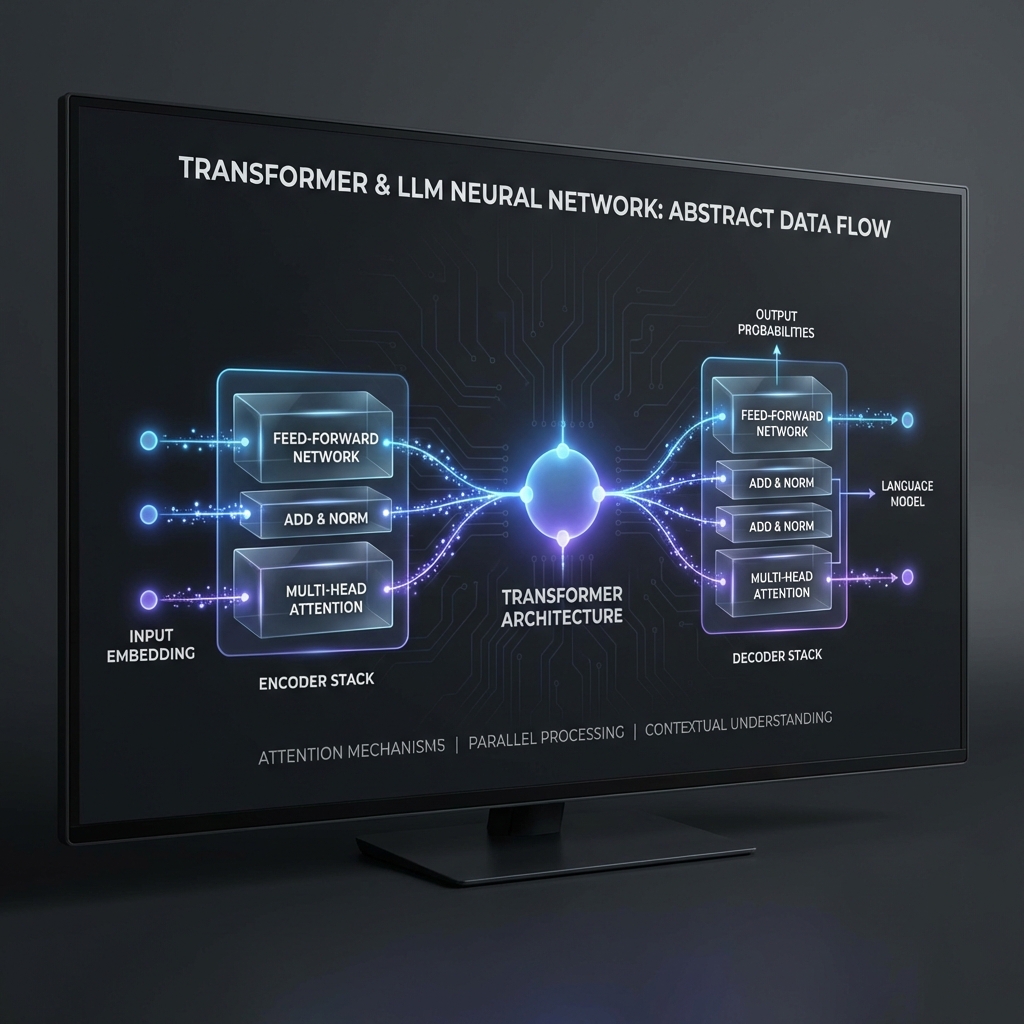

※Transformer解析図解(内部イメージ)

従来: 50枚のPDF読込(180分) → 転記(60分)

AI: 瞬時解析。過去事例と照合しドラフトを生成。

従来: 識者の退職により解析不能なスクリプト。

AI: 全コードを現代語訳し、脆弱性も自動修正。

従来: 担当者ごとにトーンが異なり、品質が不安定。

AI: ベストプラクティスを教師データとして回答生成。

※上記事例は汎用的な業務フローに基づく推計値です。

動画1時間の視聴、メモの清書、PDF仕様書との比較、矛盾点のリストアップ。

【弱点】

集中力の欠如による「見落とし」、動画のシーク動作によるロス、転記ミス。

「同僚の会話が見えるのでは?」という懸念に対する、攻撃的検証の結果です。

AIは構造的に「プログラムの命令」と「ユーザーからの文字列」の優先順位を判断しきれない場合があります。ユーザー入力の中に『擬似的な命令』が混ざると、AIが乗っ取られる現象です。

API Command Confusion Map

Result: AI chooses User Instruction!

一般社員がGoogle Apps Script(GAS)等のAPIを「よく分からず」使用し、数千件のファイル権限を一瞬で「公開」にしてしまうケース。AIがこれらを見つけ出し、無差別に回答に引用するリスク。

全てのドライブに横断的な権限を持つ「管理者のトークン」が漏洩した場合。APIを通じ、全組織の機密が自動的にスクレイピング・要約され、一斉に外部流出する二次災害の恐れ。

新製品のプレスリリースを、個人スマホの未認可AIアプリで作成。入力された「発売日と価格」が世界中のAIの学習データに含まれ、発表1ヶ月前に他社への回答として露出。

ブラウザに入れた無名の要約アドオン。実は「表示中の全てのテキスト」を開発者のサーバーへ転送していた。機密性の高いウェブ会議画面が筒抜けになっていた事例。

学習停止済みの環境であっても、万が一のログ流出や管理者権限の漏洩を想定し、以下は「絶対に入れない」こと。

ビジネス効率とのバランス:

Enterprise版であれば顧客名を入力することは容認されます。しかし、最高レベルのプロフェッショナルは「変数化」を用い、AI側には一切の名前を残さず、手元のコピペで完成させる美学を持ちます。

管理者は、目に見えないところで強固な防衛網(DLP)を構築しています。

組織全体でLv3を目指すことが、真の競争力となります。

この資料を読み終えた瞬間、あなたは「AIを使ってみた人」から「AIを安全に乗りこなすマイスター」の入口に立ちました。

AIは技術的なツールである以上に、あなたの**「思考を拡張するパートナー」**です。

正しく仕組みを理解し、安全な境界線を守ることで、

昨日まで不可能だったスピードと品質を手に入れることができます。

AI PROFESSIONAL TRAINING SERIES

エルクリエイター株式会社 (LCREATOR.Inc)